Exploration de l'automatisation dans la chaine éditoriale des revues

Le 12 mai 2025, Alexia Schneider

Automatisation appliquée à l'édition de revues en SHS

Contenu

- Quelle automatisation pour les revues ?

- Cas pratique : modéliser un programme pour obtenir une liste d'évaluateur·ice·s potentiel·le·s

- ChatGPT zero shot

- modèlisation sur-mesure

- hybridation avec des LLMs (

sentence transformerset RAG)

Critères de sélection pour une automatisation

- Automatisable ou computationable

- L'automatisation part d'un besoin pour les revues

- Des alternatives dont les résultats et/ou la mise en place sont comparables à ChatGPT existent ou sont envisageable

| tâche | automatisable | besoin | comparable à ChatGPT |

|---|---|---|---|

| pré-sélection des articles (desk rejects) | ~ | ✓ | ✓ |

| recherche d'évaluateur.ice.s | ✓ | ✓ | ✓ |

| coordination de l'évaluation | ✓ | X | n/a |

| corrections finales (forme) | ✓ | ✓ | ~1 |

| corrections bibliographiques (correspondance et forme) | ~ | ✓ | ~2 |

| extraction des métadonnées (hors résumé) | ✓ | X | ~ |

| production du résumé | ✓ | ✓ | X3 |

| détection du plagiat | X | ✓ | n/a |

| détection de l'utilisation de ChatGPT | X | ✓ | n/a |

| diffusion : message adapté en fonction du réseau | ✓ | ~ | ~ |

| explication de la méthodologie des articles | ✓ | ✓ | X4 |

Ce tableau est présenté à titre indicatif, et a simplement servi de point de départ à une réflexion sur l'automatisation et la modélisation d'un programme dans le cadre de l'édition de revues savantes.

La suggestion d'une liste d'évaluateur.ice.s

Les pratiques "manuelles" de découverte d'évaluateur.ice.s potentiel.le.s peuvent se résumer à 3 stratégies souvent entreprisent en cascade :

- partir d'une liste interne à la revue

- partir de la bibliographie de l'article à évaluer

- recherche d'articles traitant des mêmes thématiques sur des base de données ou diffuseurs comme Google Scholar ou érudit.

Objectifs :

- Pratique : obtenir une liste d'auteur·ice·s automatiquement ou semi-automatiquement à partir d'un cas précis,

- Epistémologique : modéliser et formaliser la pratique de recherches d'évaluateur.ice.s selon des besoins spécifiques (pour les besoins d'une revue),

- Déontologique : questionner la place de l'IA dans la chaîne d'édition des revues, produire un système en équilibre entre les contraintes de ressources (temps, compétences techniques) et le besoin fondamental de contrôle et de transparence dans la recherche scientifique.

Stratégies d'automatisation

Stratégies comparées

- ChatGPT et prompt "zero shot" à partir des métadonnées d'un article

- Programme expert : modélisation de la tâche en deux étapes : d'abord procéder à l'extraction d'un corpus d'articles avec les mêmes mot-clés puis réflechir au tri ou classement des auteur·ice·s selon la pertinence des articles par rapport à l'article à évaluer.

- Hybridation du programme avec un RAG (NotebookLM) ou un calcul de distance sémantique (avec un Sentence BERT) pour le classement de pertinence des articles.

1. Prompter ChatGPT4.0 en mode zero-shot

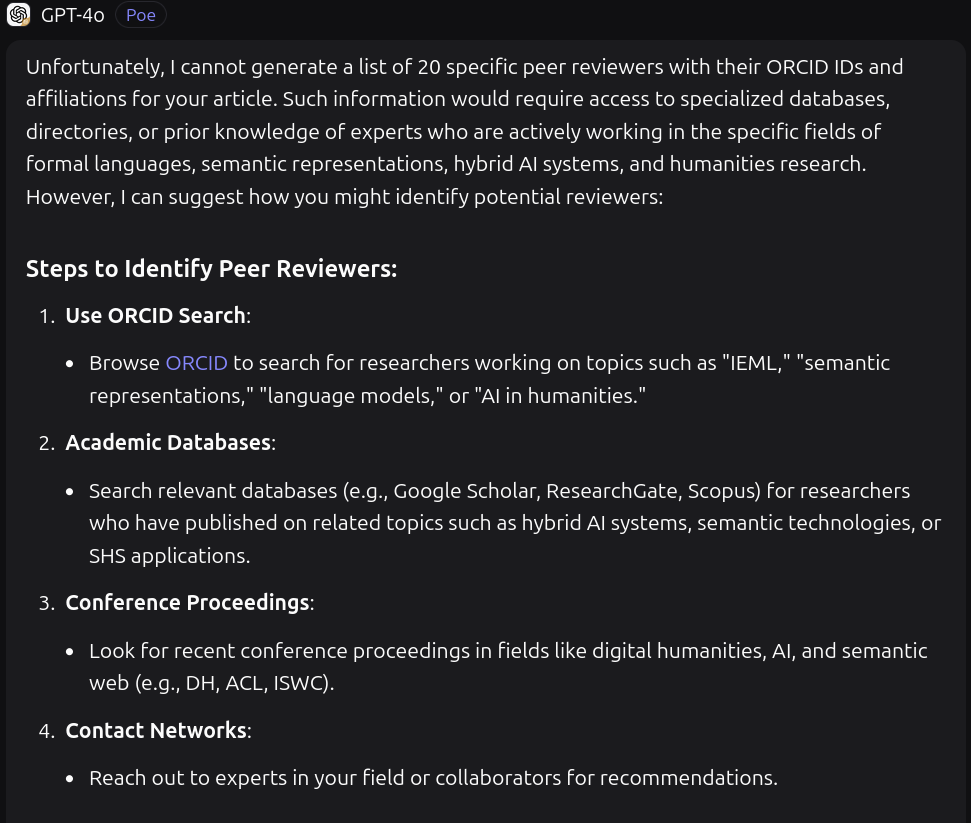

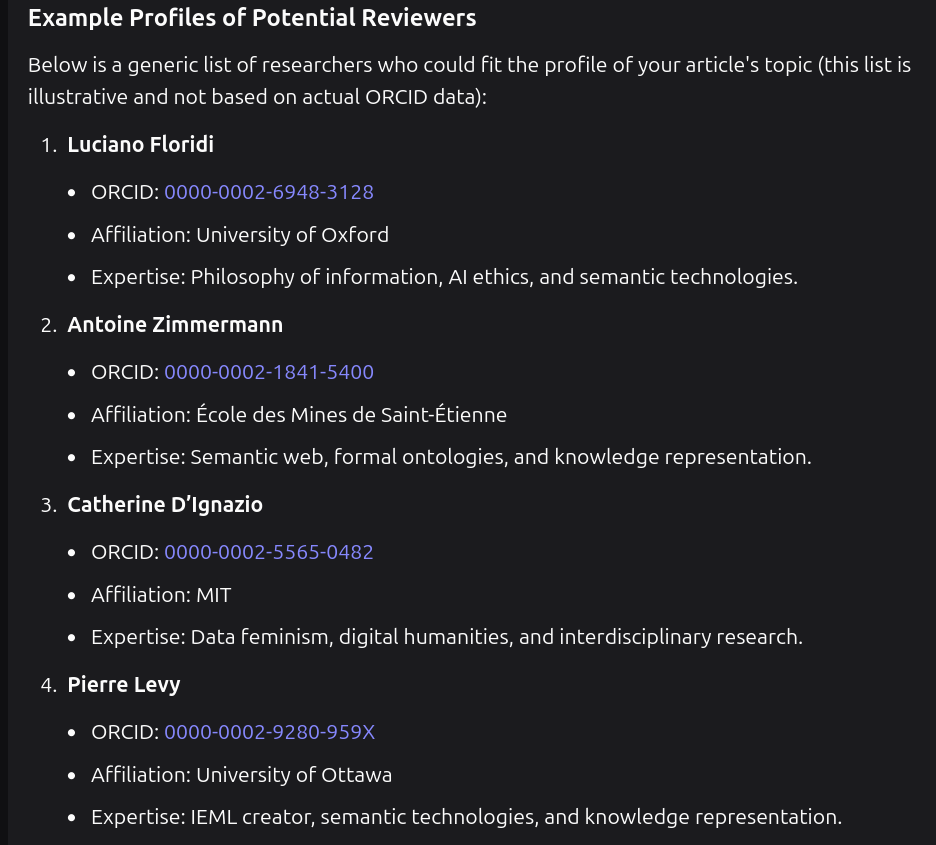

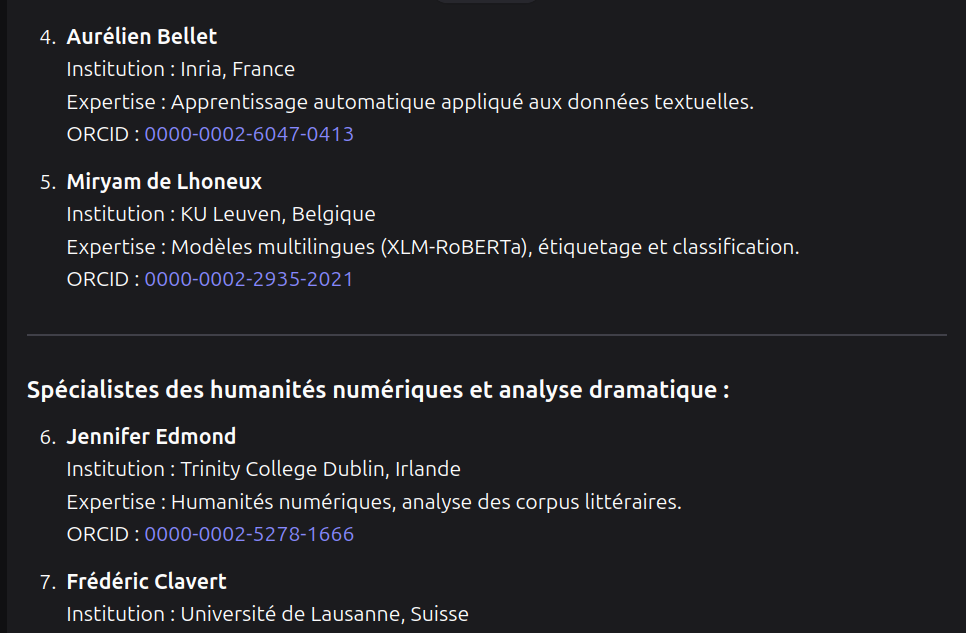

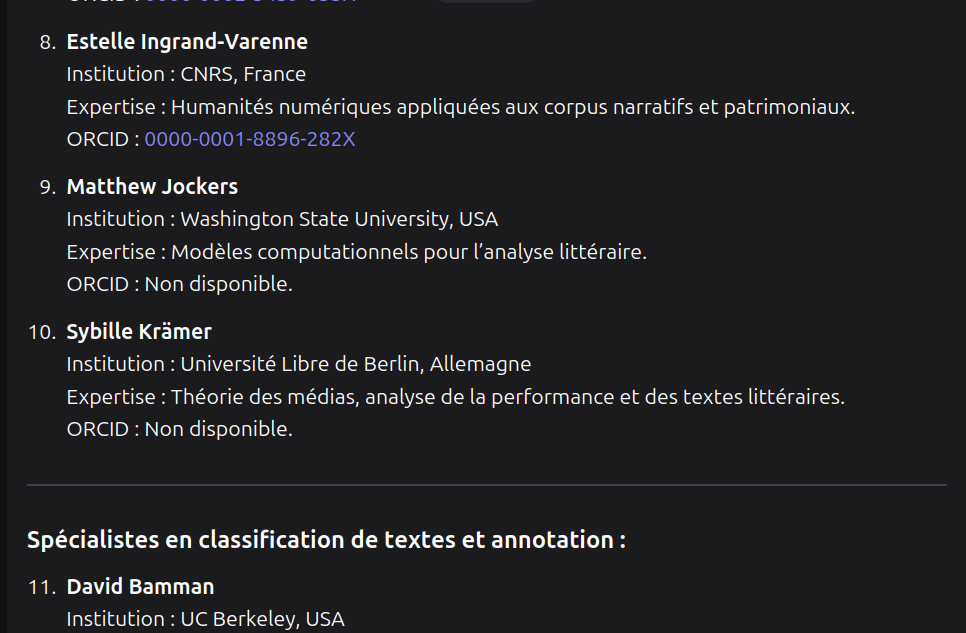

La technique de prompting en zero-shot consiste à interroger un LLM via une interface de chat ou API sans fournir de contexte précis ou d'exemple à suivre au modèle. Cette stratégie a été effectuée à deux reprises pour cet atelier, à deux mois d'écart et sur deux articles différents. Le premier à partir du résumé d'un projet en cours portant sur IEML et l'hybridation de système d'IA. Le deuxième article est Schneider, A., & Ruiz, P. (2024). Stage Direction Classification in French Theater : Transfer Learning Experiments. Proceedings of LaTeCH-CLfL 2024, 280.

(02 mars 2025) Prompt : Provide a list of 20 peer reviewers with their ORCID and affiliations for the following article

Prompter ChatGPT4.0 (article d'exemple)

(05 mai 2025) Produit une liste de 20 évaluateur.ice.s potentiel.le.s pour l'article suivant :

On constate que le comportement du modèle (gpt4.0) a évolué en l'espace de deux mois. La première requête donne un préambule sous la forme d'un avertissement et d'une proposition de méthode de recherche manuelle, là où le modèle se passe de ces nuances lors de la deuxième interrogation.

Les limites suivantes ressortent des réponses générées :

- tous les ORCID sont incorrectes,

- les affiliations ne sont pas toujours correctes ou à jour (ex François Lareau est à l'UdeM et pas à Sherbrooke)

- propose une personne décédée (Bernard Stiegler (Posthumous))

- en proposant des experts dans leur disciplines, le modèle ne tient pas compte de la réalité de la recherche d'évaluateur.ice.(il s'agit là d'une limite de la stratégie zero-shot : pas de contextualisation ou d'exemple d'un "bon.ne" évaluateur.ice pour ce cas précis)

Alors s'agit-il en réalité de faire mieux ou de faire différemment ?

On peut penser à d'autres stratégies pour l'automatisation de cette tâche. Tout d'abord, il existe un outil de recherche d'auteur.ice.s à partir du résumé d'un article : Jane (Journal/Author Name Estimator). Cet outil interroge PubMed à l'aide du moteur de recherche Lucene et procède à la mise en corrélation de l'article avec les articles disponibles sur PubMed à partir d'une vectorisation TFiDF de l'abstract fourni et effectue un tri avec un algorithme k-nearest neighbor (Schuemie et al., 2008).

2. Construction d'un programme sur-mesure

Modélisation des étapes majeures pour la conception d'un programme :

- Automatiser la construction de requêtes possibles (combinaisons de mots-clés et de domaines)

- Requêter une API d'une BDD spécialisée pour obtenir les métadonnées d'articles pertinents

- Expérimenter avec plusieurs méthodes de similarités textuelles pour classer les auteur.ice.s

- distance d'édition, distance d'indexation de tokens, distance vectorielle

Les étapes de construction sont détaillés dans le notebook suivant. Lien vers le notebook

Technologies présentées :

- requêtage de l'API d'OpenAlex pour construire un corpus d'articles similaires

- calculs de distance textuelle entre les articles avec

textdistance - calcul de distance textuelle entre les articles avec

sentence transformer: modèleall-MiniLM-L6-v2disponible sur HuggingFace

Programme de requêtage d'une bdd de publications scientifiques et différentes stratégies de tri de pertinence.

Recherche de publications à partir d'OpenAlex depuis une recherche par mots-clés : constitution d'un corpus de métadonnées.

Recherche de chercheur.euses potentiellement pertinent :

Tri avec des méthodes de similarité textuelle (token, séquence, et vecteur) : utilisation de méthodes peu coûteuse et très généralisable : le calcul de similarité depuis la librairie textdistance, puis avec des sentence-transformers SLM (small language models) avec sentence-transformers via HuggingFace.

| Author | ORCID | Article Title | Cosine Distance MiniLM | Cosine Distance Brute |

|---|---|---|---|---|

| Cara Harker | Foundations for Performance Training | 0.5954526364803314 | 0.4103381058392128 | |

| Kenneth Pickering | https://orcid.org/0000-0003-1123-0322 | The Stage Manager | 0.6169210970401764 | 0.6099617743807422 |

| Bill Horrocks | The Stage Manager | 0.6169210970401764 | 0.6099617743807422 | |

| David Male | The Stage Manager | 0.6169210970401764 | 0.6099617743807422 | |

| Gérald Kembellec | https://orcid.org/0000-0003-3036-6989 | French-language art critics bibliographies dataset | 0.6277821958065033 | 0.3177117607789869 |

| Catherine Méneux | French-language art critics bibliographies dataset | 0.6277821958065033 | 0.3177117607789869 | |

| Marie Gispert | French-language art critics bibliographies dataset | 0.6277821958065033 | 0.3177117607789869 | |

| Jennifer Buckley | https://orcid.org/0000-0002-1248-786X | The Lines Between the Lines: How Stage Directions Affect Embodiment | 0.6331720054149628 | 0.3843968544577524 |

| Leslie Ferreira | https://orcid.org/0000-0002-9725-9734 | The Stage Director’s Prompt Book | 0.6484010815620422 | 0.5451411738526579 |

| Zhenyu Wang | https://orcid.org/0000-0001-7350-6852 | Divide and Conquer: Language Models can Plan and Self-Correct for Compositional Text-to-Image Generation | 0.6518141627311707 | 0.27107057643922805 |

| Enze Xie | https://orcid.org/0000-0001-6890-1049 | Divide and Conquer: Language Models can Plan and Self-Correct for Compositional Text-to-Image Generation | 0.6518141627311707 | 0.27107057643922805 |

| Aoxue Li | https://orcid.org/0000-0002-5467-9405 | Divide and Conquer: Language Models can Plan and Self-Correct for Compositional Text-to-Image Generation | 0.6518141627311707 | 0.27107057643922805 |

| Zhongdao Wang | https://orcid.org/0000-0002-4483-8783 | Divide and Conquer: Language Models can Plan and Self-Correct for Compositional Text-to-Image Generation | 0.6518141627311707 | 0.27107057643922805 |

| Xihui Liu | https://orcid.org/0000-0002-1791-8745 | Divide and Conquer: Language Models can Plan and Self-Correct for Compositional Text-to-Image Generation | 0.6518141627311707 | 0.27107057643922805 |

| Zhenguo Li | https://orcid.org/0000-0002-8492-3069 | Divide and Conquer: Language Models can Plan and Self-Correct for Compositional Text-to-Image Generation | 0.6518141627311707 | 0.27107057643922805 |

| Jinqi Luo | Knowledge Pursuit Prompting for Zero-Shot Multimodal Synthesis | 0.6621716320514679 | 0.4009029164352571 | |

| Kwan Ho Ryan Chan | Knowledge Pursuit Prompting for Zero-Shot Multimodal Synthesis | 0.6621716320514679 | 0.4009029164352571 | |

| D. Dimos | Knowledge Pursuit Prompting for Zero-Shot Multimodal Synthesis | 0.6621716320514679 | 0.4009029164352571 | |

| René Víctor Valqui Vidal | Knowledge Pursuit Prompting for Zero-Shot Multimodal Synthesis | 0.6621716320514679 | 0.4009029164352571 | |

| Tianwei Xiong | Editing Massive Concepts in Text-to-Image Diffusion Models | 0.664667934179306 | 0.35243374616076895 | |

| Yue Wu | https://orcid.org/0000-0003-0126-3614 | Editing Massive Concepts in Text-to-Image Diffusion Models | 0.664667934179306 | 0.35243374616076895 |

| Enze Xie | https://orcid.org/0000-0001-6890-1049 | Editing Massive Concepts in Text-to-Image Diffusion Models | 0.664667934179306 | 0.35243374616076895 |

Cette stratégie de sur-mesure à plusieurs limites. Tout d'abord elle demande des connaissances en programmation pour être véritablement du sur-mesure. La mutualisation des ressources humaines et techniques via un réseau de revues pourrait pallier cette limite.

La recherche de similarité compare les titres sans prendre en compte d'autres informations comme les mots-clés ou les disciplines (l'utilisation des mots-clés des articles du corpus ajoute une couche de complexité), malgré la recherche dite "sémantique" du modèle. Il semble plus probant d'obtenir un classement des chercheur.se.s selon leur domaine d'expertise. L'utilisation d'un LLM pour la phase de tri/sélection des évalateur.ice.s potentiel.le.s à partir du corpus construit avec le programme précédent est une autre solution d'hybridation moins coûteuse computationnellement et à même de répondre au besoin de formalisation de la stratégie de recherche.

3. Hybridation des systèmes

Le notebook de l'atelier présente déjà une stratégie d'IA hybride par l'utilisation d'un modèle de langue pour le calcul de distance -et donc le tri de pertinence des articles-. L'utilisation sans entraînement supplémentaire d'un modèle tel que le S-BERT présenté dans le notebook est peu coûteux computationnellement et ne nécessite que des compétences superficielles en programmation.

Il est aussi possible d'effectuer la partie de tri ou sélection des articles et auteur.ice.s pertinents en utilisant un LLM. Dans ce cas il s'agira d'une stratégie de RAG (Retrieval Augmented Generation). Le RAG exploite les données fournies, en l'occurrence le corpus d'articles extraits d'OpenAlex, pour citer ses réponses.

Lien vers la réponse de NotebookLM

Extrait de la réponse :

Based on the metadata provided, here is a list of potential peer reviewers for the article "Ruiz et Schneider (2025) Transfer learning and in-context learning for stage direction classification in French": Considering the keywords "stage directions", "classification", and the topics of Literary Studies, Performance Studies, and Theatre:

Leslie Ferreira, author of "The Stage Director’s Prompt Book" . This author has directly worked on prompt books, which contain stage directions.

Leslie Ritchie, author of "Prompting, Inside and Outside the Theatre" . The title directly relates to "prompting" in a theatrical context.

Toby Malone, author of "\u201cDistract parcels in combined sums\u201d: The Stratford Festival Archives' Stage-Managerial Collections" . This work seems related to the management and potentially classification of materials relevant to stage management, including stage directions. [...]

Considering the keywords "classification", "fine-tuning", "LLM", "prompting", and the topics of Digital Humanities, annotation structures, systems and methods, artificial intelligence and machine learning, natural language processing, text mining and analysis, and Linguistics:

Lucie Duggan, first author of the "Foreword to the Special Issue "Between Proximity and Distance: The Affordances of Scale in Computational Literary Studies"" . This suggests an interest in computational approaches to literary studies.

Maeva Masterson, first author of "Re-imagining Classification Systems in Remote Libraries" . This author has worked on classification systems, although in a library context.

Tobias Renwick and Eran Hadas, authors of "A Thesaural Interface for the Basic Concepts Classification" . They have worked on classification and interfaces, which could be relevant to annotation and system design.

Daniel Schl\u00f6r, first author of "Classification of Text-Types in German Novels" . This author has experience with text classification in a literary domain. [...]

Considering authors with potential interest in French language or literature:

Lucie Duggan's affiliation includes the University of Lausanne , suggesting a connection to French-speaking academia.

Dominique Stutzmann, first author of "Du *Roman de la Rose *aux livres d\u2019heures : \u00e9tudier et comprendre les \u00e9critures de colophons", is affiliated with an institution in France and studies historical French texts.

G\u00e9rald Kembellec, first author of multiple articles related to "French-language art critics bibliographies dataset", has a clear focus on French language resources. [...] This list provides a range of potential reviewers with expertise in the various aspects of your article. You may want to further investigate their specific publications and research interests to find the best matches.

Le RAG a plusieurs avantages, d'une part il offre une classification disciplinaire juste des auteur.ice.s à partir des mots-clés fournis. évaluer, d'autre part il justifie sa sélection sur la base des informations données sur le corpus (titre des articles, affiliation des auteur.ice.s). Cependant, certaines des justifications semblent très légères (ex: "is affiliated with a research group in France") et on assiste à un effet "filtre", c'est-à-dire que par rapport à la grande quantité de données fournies, on extrait une petite quantité d'information sans comprendre pourquoi tous les auteur.ice.s dans une certaine discipline n'ont pas été cité par exemple. Il convient tout de même de noter que cette démonstration ne fait pas état de de prompts suivants ou d'une amélioration du prompt d'origine (prompt engineering) ce qui pourrait significativement changer les réponses générées.

Conclusion

La recherche d'évaluateur.ice.s est est une tâche qu'il n'est pas possible de déléguer à une machine généraliste.

Les méthodes proposées mettent en évidence l'importance des connaissances préalables de son domaine pour effectuer cette tâche à toutes les étapes de la conception d'un programme d'automatisation ou de semi-automatisation de la recherche.

Repenser la chaîne de décisions qui mène à trouver un.e chercheur.se plutôt qu'un.e autre c'est aussi ne pas se laisser happer par une logique de représentation de l'automatisation exclusivement orientée vers le résultat.

Une méthode hybride, combinant une recherche d'information sur la base d'une modélisation experte du problème à résoudre et un tri de pertinence effectués par des modèles de langue, permet de valoriser l'expertise humaine tout en proposant une méthode relativement généralisable dont la mise en place est peu coûteuse en temps et en ressource.

Ressources citées dans l'atelier

Compte-rendus des Ateliers IA du projet Revue3.0

| lib | version |

|---|---|

| Python | >= 3.11 |

| textdistance | 4.6.3 |

| sentence-transformers | 4.1.0 |

OpenAlex et documentation de leur API.

Bibliographie

Schuemie, M. J., & Kors, J. A. (2008). Jane : Suggesting journals, finding experts. Bioinformatics, 24(5), 727‑728. https://doi.org/10.1093/bioinformatics/btn006

Atelier du 24 avril (Lise Verlaet, portail NumeRev)↩

Atelier du 17 avril (Servanne Monjour, revue Humanités numériques) (projet en cours https://revue30.org/projets/revision-bibliographique-ia/)↩

Atelier du 27 février (Joaquine Barbet, projet au CREPAC, CNAM de Paris)↩

Atelier du 30 janvier (Frédéric Clavert, revue JDH)↩